http://www.pcgameshardware.de/Monitor-D ... t-1094860/tequilio hat geschrieben:Ich sehe da viel mehr fps bei genannten Karten um ehrlich zu sein.Roland von Gilead hat geschrieben: Also alles ab 970/980/1060/RX470/RX480 wird für BF1 mit Ultrasettinge@HD reichen meiner Meinung nach und um die 60fps liefern .....

Denke eher in Richtung 80.

Wieso 120 frames Roland? Warum genau diese Zahl

BF1 Hardware

Moderator: Moderatoren

- Roland von Gilead

- verdammt coole sau

- Beiträge: 13180

- Registriert: 02.07.2003, 20:05

- Wohnort: wo die Kühe wilder als die Frauen sind !

- Kontaktdaten:

- Roland von Gilead

- verdammt coole sau

- Beiträge: 13180

- Registriert: 02.07.2003, 20:05

- Wohnort: wo die Kühe wilder als die Frauen sind !

- Kontaktdaten:

Danke für den Tipp, hab ich scheinbar noch nie abgeschaltet - hatte ich selbst in BF4 auf onFussballgott hat geschrieben:War mir auch aufgefallen. Da würde ich nichts mehr treffen, und mir würde obendrein vermutlich noch schlecht werden.tequilio hat geschrieben:Roland Fischauge?

Ich hatte immer 90 bei field of view in den alten BF Teilen, dass war , für mich , die absolute Grenze.

Und ADS FOV würde ich bei so hohen Werten erst recht abschalten, dann erkennt man wenigstens was, sobald man anvisiert.

Das heißt der Bildschirm,gibt nicht mehr her als seine taktrate in HerzRoland von Gilead hat geschrieben:http://www.pcgameshardware.de/Monitor-D ... t-1094860/tequilio hat geschrieben:Ich sehe da viel mehr fps bei genannten Karten um ehrlich zu sein.Roland von Gilead hat geschrieben: Also alles ab 970/980/1060/RX470/RX480 wird für BF1 mit Ultrasettinge@HD reichen meiner Meinung nach und um die 60fps liefern .....

Denke eher in Richtung 80.

Wieso 120 frames Roland? Warum genau diese Zahl

Wenn man Bsp 60hz hat bringen einem 140 fps im Game nichts, verstehe ich das richtig ?

- Roland von Gilead

- verdammt coole sau

- Beiträge: 13180

- Registriert: 02.07.2003, 20:05

- Wohnort: wo die Kühe wilder als die Frauen sind !

- Kontaktdaten:

Das ist quatsch.

Würde man weniger nach Gefühl sondern mehr nach Objektivität handeln wäre der Markt deutlich ausgeglichener. Der Treiber und besonders die Oberfläche ist bei AMD deutlich moderner. Selbst eine Auto-Update Funktion für den grafikkartentreiber gibt es welche bisher problemlos funktioniert. Da hat sich einiges getan.

Mit diesen hotfixes wird nvidia auch häufiger zu kämpfen haben, da auf GCN entwickelt wird. Überrascht daher nicht, dass es gerade bei nvidia am Anfang harkt. Habe ich hier bereits woanders geschrieben.

Objektiv betrachtet gibt/gab es bei nvidia in bf1 absturtzprobleme. Bei AMD läuft alles rund. Selbst ein crossfire Profil für das ungeliebte DX11 hat man bereits geliefert. Das fehlt leider noch bei nvidia.tequilio hat geschrieben:Vom Gefühl her ganz klar NVIDIA.

Treiber super, wie immer.

Würde man weniger nach Gefühl sondern mehr nach Objektivität handeln wäre der Markt deutlich ausgeglichener. Der Treiber und besonders die Oberfläche ist bei AMD deutlich moderner. Selbst eine Auto-Update Funktion für den grafikkartentreiber gibt es welche bisher problemlos funktioniert. Da hat sich einiges getan.

Mit diesen hotfixes wird nvidia auch häufiger zu kämpfen haben, da auf GCN entwickelt wird. Überrascht daher nicht, dass es gerade bei nvidia am Anfang harkt. Habe ich hier bereits woanders geschrieben.

Zuletzt geändert von G3cko am 07.09.2016, 09:58, insgesamt 1-mal geändert.

- Fussballgott

- Geschäftsmodell

- Beiträge: 2351

- Registriert: 10.12.2002, 15:48

- Wohnort: Ruhrpott

- Roland von Gilead

- verdammt coole sau

- Beiträge: 13180

- Registriert: 02.07.2003, 20:05

- Wohnort: wo die Kühe wilder als die Frauen sind !

- Kontaktdaten:

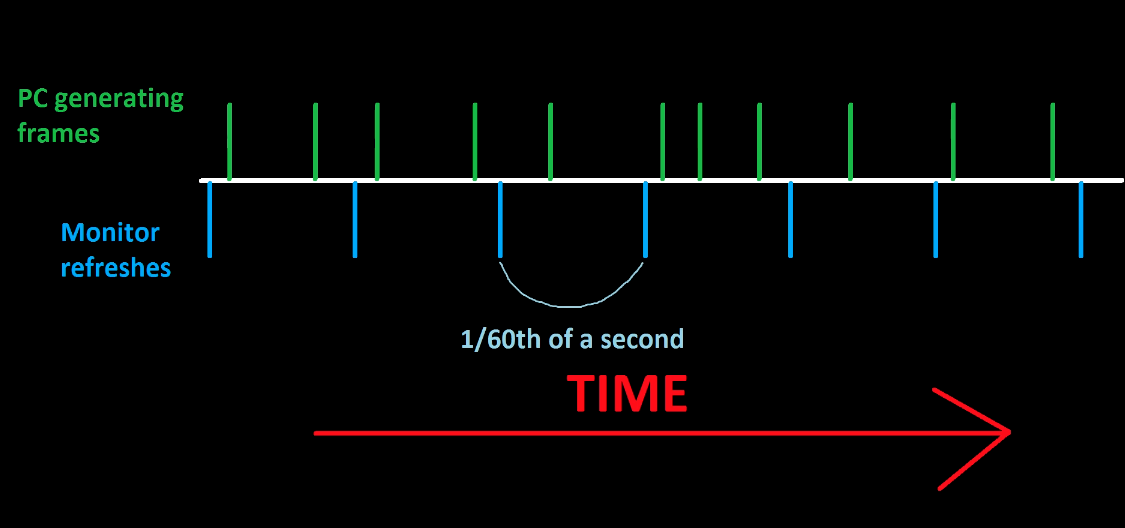

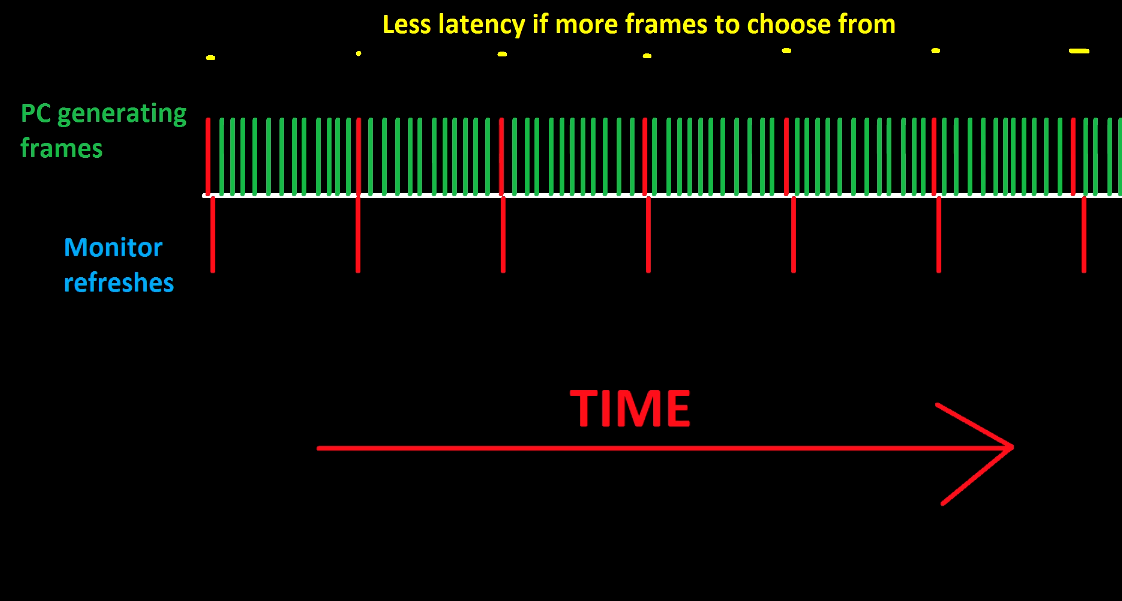

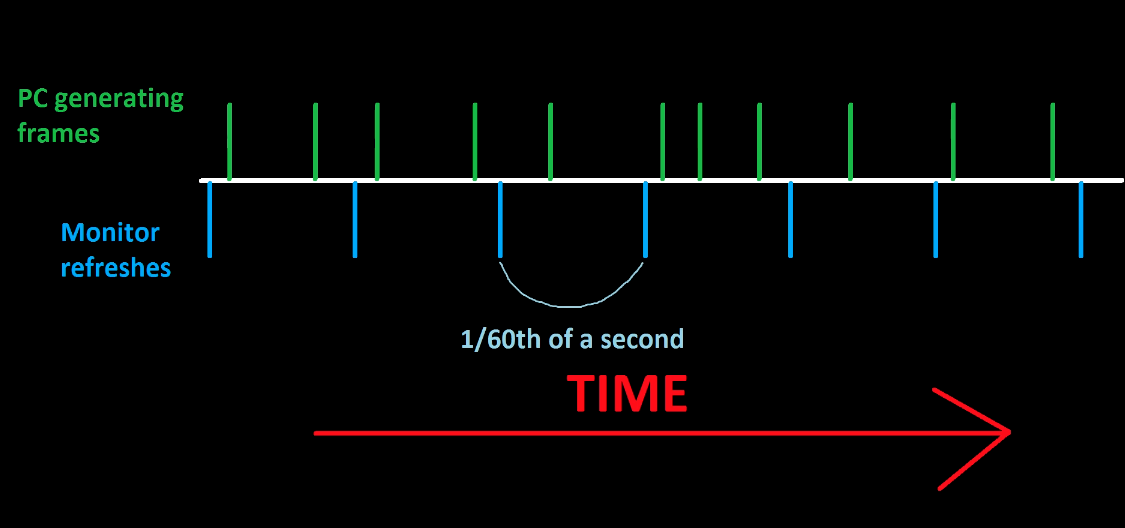

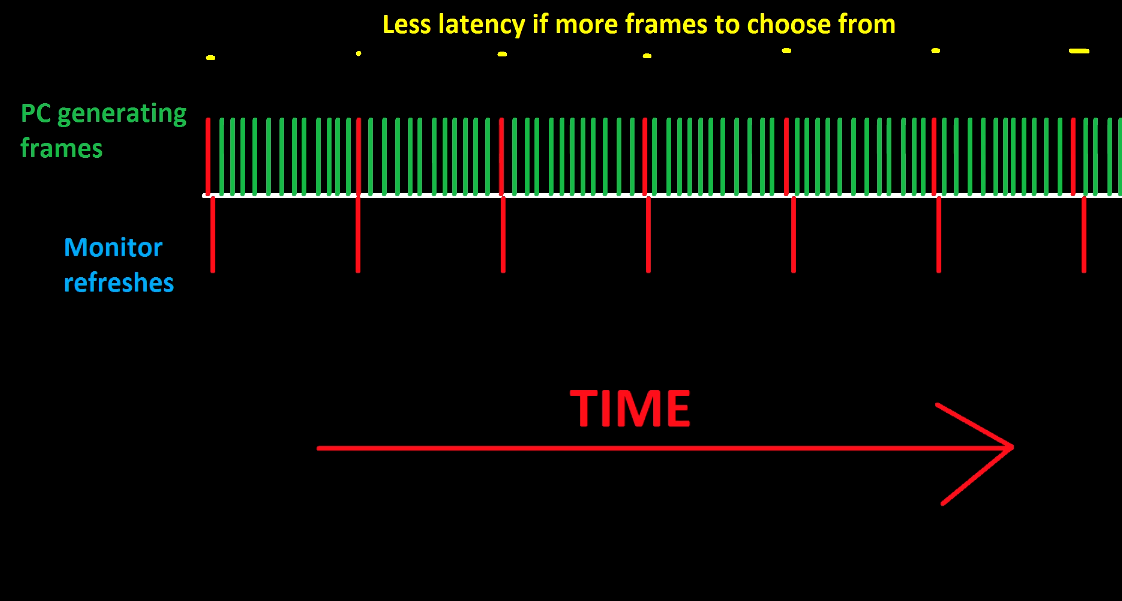

Zum Verständnis --> ein 60hz monitor kann nicht mehr als 60 Bilder/s darstellen, das ist schonmal unwiederlegbarer Fakt.

Allerdings ist es natürlich so, wenn die 60 Bilder der VGA zu Unterschiedlichen Zeiten kommen, wie der TFT seine Bildwiederholfrequenz hat, das ein o. andere Bild "dropt" und damit weniger darstellt - schaft die VGA mehr frames zum selben Zeitpunkt, ist die gefahr geringer das ein Bild dropt und es einem vorkommt das bild läuft unruhiger.

Deswegen gibt es aber Vsync in fast jedem Spiel - das die 60 Bilder von der VGA syncron mit der Bildwiederholrate des Monitor sind. Deswegen ist es natürlich sinnig das die VGA mehr als 60 Frames schaft um nicht unter grosser Belastung unter die 60 Bilder gerät.

Also zur korrektur klar macht es Sinn das die VGA > 60fps, liefert aber ein 60hz Monitor kann trotzdem nur 60 Bilder/s anzeigen.

Aber danke gecko für deine verständliche Grafik mit der dazugehörigen Information.

Aber einmal mit einem > 100hz Monitor gespielt mit entsprechenden Frames der VGA und ihr wollt kein 60hz mehr

EDIT: Zu deinem Edit

Wenn du nicht wie ein AMD Vertreter klingst, dann weiss ich ja nicht muahha, schönere Treiberoberfläche ....

muahha, schönere Treiberoberfläche ....

PS: 14 Stunden seit Beginn der beta gespielt ( mit der 970 wie auch der 1070), einen einzigen Absturz beim Mapchange - keine Grafikfehler - was mache ich falsch?

PPS: VRAM - gestern in Ultra @ HD gespielt - max 3,4GB VRAM in Beschlag

Allerdings ist es natürlich so, wenn die 60 Bilder der VGA zu Unterschiedlichen Zeiten kommen, wie der TFT seine Bildwiederholfrequenz hat, das ein o. andere Bild "dropt" und damit weniger darstellt - schaft die VGA mehr frames zum selben Zeitpunkt, ist die gefahr geringer das ein Bild dropt und es einem vorkommt das bild läuft unruhiger.

Deswegen gibt es aber Vsync in fast jedem Spiel - das die 60 Bilder von der VGA syncron mit der Bildwiederholrate des Monitor sind. Deswegen ist es natürlich sinnig das die VGA mehr als 60 Frames schaft um nicht unter grosser Belastung unter die 60 Bilder gerät.

Also zur korrektur klar macht es Sinn das die VGA > 60fps, liefert aber ein 60hz Monitor kann trotzdem nur 60 Bilder/s anzeigen.

Aber danke gecko für deine verständliche Grafik mit der dazugehörigen Information.

Aber einmal mit einem > 100hz Monitor gespielt mit entsprechenden Frames der VGA und ihr wollt kein 60hz mehr

EDIT: Zu deinem Edit

Wenn du nicht wie ein AMD Vertreter klingst, dann weiss ich ja nicht

PS: 14 Stunden seit Beginn der beta gespielt ( mit der 970 wie auch der 1070), einen einzigen Absturz beim Mapchange - keine Grafikfehler - was mache ich falsch?

PPS: VRAM - gestern in Ultra @ HD gespielt - max 3,4GB VRAM in Beschlag

100fps sind auch auf einem 60hz Monitor wahrnehmbar. Ob man das brauch muss jeder für sich entscheiden. Die syncronisation zwischen Monitor hat, wenn ich das richtig in Erinnerung habe einen eigene latenz. Das frisst natürlich wieder den Vorteil auf. Es geht ja um eine verbesserte ein und Ausgabe, daher um eine niedrige latenz.

Wie gesagt sind das zu den Treibern aussagen von PCGH, welche diverse Modelle durchgetestet habe. Probleme gabs auch vorrangig mit älteren nvidia Modellen.

Mir ging es um den Ausdruck: gefühlt läuft's mit nvidia besser. Wenn man nicht gerade selbst beide hersteller testet kann man das noch nichteinmal bewerten. Das ist also rein subjektiv. Dann lieber die aussagen von einem Fachmagazin.

Sicherlich sind 3,5GB VRAM nicht extrem viel, bei so mancher modernen Karte, aber die meisten Kepler Karten haben mit 2 GB deutlich weniger. Die 3GB meiner 7970 sind also schon gut so dimensioniert. Ebenso sind eben heute 8GB bei einem neukauf sinnvoll, unabhängig ob man diese stand heute braucht.

Wie gesagt sind das zu den Treibern aussagen von PCGH, welche diverse Modelle durchgetestet habe. Probleme gabs auch vorrangig mit älteren nvidia Modellen.

Mir ging es um den Ausdruck: gefühlt läuft's mit nvidia besser. Wenn man nicht gerade selbst beide hersteller testet kann man das noch nichteinmal bewerten. Das ist also rein subjektiv. Dann lieber die aussagen von einem Fachmagazin.

Sicherlich sind 3,5GB VRAM nicht extrem viel, bei so mancher modernen Karte, aber die meisten Kepler Karten haben mit 2 GB deutlich weniger. Die 3GB meiner 7970 sind also schon gut so dimensioniert. Ebenso sind eben heute 8GB bei einem neukauf sinnvoll, unabhängig ob man diese stand heute braucht.

Langsam versteh ich Roland...G3cko hat geschrieben:

Mir ging es um den Ausdruck: gefühlt läuft's mit nvidia besser. Wenn man nicht gerade selbst beide hersteller testet kann man das noch nichteinmal bewerten. Das ist also rein subjektiv. Dann lieber die aussagen von einem Fachmagazin.

Wie kommst du drauf das ich nicht schon AMD Besitzer war? Tut mir leid, aber alleine mit deinem Unwissen eine solche Aussage zutätigen ist einfach nur

Aber bitte, dass musst du selber entscheiden.

Zur Sache:

Ich war natürlich schon AMD Kunde und hatte dort einfach irrsinnig schlechte Erfahrungen gemacht.

Genau u.a. mit dem Treiber, dieser wunderschöne beschissene Catalyst Mist oder wie der Kram auch noch geheißen haben mag.

Mir kommt der Dreck auf alle Fälle nie mehr wieder in den PC.

Selbst bei einem Preisunterschied von 50% zu NVIDIA, würde ich aus meiner eigenen Erfahrung immer NVIDIA vorziehen.

Ich persönlich hatte noch nie Probleme mit deren Karten und ich hatte auch mittlerweile schon ein paar Grakas in meinem Leben.

Von Abstürzen oder dergleichen habe ich bei unseren BF1 Spielern noch nichts gehört.

Das zählt für mich und nicht was irgendjemand im Netz schreibt.

Ich persönlich gebe viel viel mehr auf persönliche Erfahrungsberichte unserer Jungs hier, als im Internet lange nach Quellen zu suchen von Leuten die ich nicht kenne und nicht weiß ob sie nicht doch ein wenig "abhängig" sind.

Mit unseren Erfahrungsberichten hab ich schon ganze PC's zusammen gebaut und bin immer sehr gut damit gefahren.

- Roland von Gilead

- verdammt coole sau

- Beiträge: 13180

- Registriert: 02.07.2003, 20:05

- Wohnort: wo die Kühe wilder als die Frauen sind !

- Kontaktdaten:

... und ich wäre AMD sogar aufgeschlossen  , dafür müsste mich aber erstmal wieder eine VGA von den reinen Werten überzeugen. Und das tut momentan halt keine. Beste Beispiel der Vergleich 1060 vs. R480 - entweder sind alle online magazine gekauft oder die 1060 ist tatsächlich : "schneller billiger leiser & sparsamer" ABER dann kommt wieder:

, dafür müsste mich aber erstmal wieder eine VGA von den reinen Werten überzeugen. Und das tut momentan halt keine. Beste Beispiel der Vergleich 1060 vs. R480 - entweder sind alle online magazine gekauft oder die 1060 ist tatsächlich : "schneller billiger leiser & sparsamer" ABER dann kommt wieder:

WANN, tut sie das denn ? in aktuellen Benches tut sie es nicht ....Aber sie hat 2GB Mehr Ram - die RX480 - das reisst alles raus !!!!!11!!!11

na, super .....ABER in 2 oder 3 oder 16 Jahren - dann ist sie schneller !!1!!!! 1 Wg. GCN & Konsolen Port Blabla - Dann liefert sie in "dann aktuellen" Spiel 30fps auf Vesa Standard & Nvidia 10 fps weniger - das sind 30% !!! 11! ätschibätsch

- Licherkette

- Administrator

- Beiträge: 1288

- Registriert: 08.12.2002, 13:46

- Wohnort: Langenselbold

Es geht mir nicht um gefühlt, mir geht es um Zukunft. Ich habe vor ca 4 Jahren eine AMD HD7850 gekauft, die läuft heute noch.

Sie war die sparsamste im Feld, glaube Verbrauch um die 100 Watt. Performance Mittelmaß, bis BF3 hat sie auf mittleren Settings gut mithalten können.

Seit BF4 ist sie unterirdisch.

bei The Division bekomme ich manchmal nur noch Polygonmatsch, ist aber bei keinem anderen Spiel so. Normalerweise würde ich sagen ein Speicherbaustein hat ne Macke, aber hier würde ich es auf zu wenig verfügbaren Speicher schieben.

Mit den AMD-Treibern habe ich keine Probleme, wie es bei nVidia aussieht will ich von euch wissen.

Nach dem, was ich gelesen habe, werden Spiele in Zukunft wohl mindestens 4GB VRam der Graka locker verwenden, wenn nicht sogar mehr.

Was ich gerne wissen würde ist, komme ich mit weniger Speicher hin, wenn ich die Details zurücknehme? Oder ist 8GB obligatorisch, wenn ich auf WQHD gehen will?

Win10 möchte ich so lange wie möglich umgehen, am liebsten wäre mir Vulkan, da Plattformunabhängig und später auch mit Linux möglich. Ich benutze Windows zu Hause eigentlich nur noch zum Zocken.

Die Frage ist: Werden Zocker jemals auf Linux umsteigen oder Microsofts Diktatur treu bleiben?

Was mich momentan vom Kauf einer RX480 abhält ist eigentlich weniger die Performance, als die Tatsache, dass die Karte z.B. beim Desktop 17 Watt frisst, während nVidia mit 7 bei 2 Monitoren hinkommt.

Und dass sie bei Volllast ca. 160 Watt genehmigt anstatt wie bei nVidia ca. 140 Watt für deutlich mehr Frames/s.

An nVidia stört mich der Starrsinn das "async computing" nicht zu unterstützen, was gleichbedeutend mit weniger Leistung bei Vulkan und DX12 ist, wobei ich denke, das ist das kleinere Übel oder?

Sie war die sparsamste im Feld, glaube Verbrauch um die 100 Watt. Performance Mittelmaß, bis BF3 hat sie auf mittleren Settings gut mithalten können.

Seit BF4 ist sie unterirdisch.

bei The Division bekomme ich manchmal nur noch Polygonmatsch, ist aber bei keinem anderen Spiel so. Normalerweise würde ich sagen ein Speicherbaustein hat ne Macke, aber hier würde ich es auf zu wenig verfügbaren Speicher schieben.

Mit den AMD-Treibern habe ich keine Probleme, wie es bei nVidia aussieht will ich von euch wissen.

Nach dem, was ich gelesen habe, werden Spiele in Zukunft wohl mindestens 4GB VRam der Graka locker verwenden, wenn nicht sogar mehr.

Was ich gerne wissen würde ist, komme ich mit weniger Speicher hin, wenn ich die Details zurücknehme? Oder ist 8GB obligatorisch, wenn ich auf WQHD gehen will?

Win10 möchte ich so lange wie möglich umgehen, am liebsten wäre mir Vulkan, da Plattformunabhängig und später auch mit Linux möglich. Ich benutze Windows zu Hause eigentlich nur noch zum Zocken.

Die Frage ist: Werden Zocker jemals auf Linux umsteigen oder Microsofts Diktatur treu bleiben?

Was mich momentan vom Kauf einer RX480 abhält ist eigentlich weniger die Performance, als die Tatsache, dass die Karte z.B. beim Desktop 17 Watt frisst, während nVidia mit 7 bei 2 Monitoren hinkommt.

Und dass sie bei Volllast ca. 160 Watt genehmigt anstatt wie bei nVidia ca. 140 Watt für deutlich mehr Frames/s.

An nVidia stört mich der Starrsinn das "async computing" nicht zu unterstützen, was gleichbedeutend mit weniger Leistung bei Vulkan und DX12 ist, wobei ich denke, das ist das kleinere Übel oder?

Wissen ist Macht, nix Wissen macht auch nix

- ftn|smokin'

- sie nannten ihn viagra

- Beiträge: 2571

- Registriert: 28.06.2003, 15:09

- Wohnort: NRW

Krass, ich hab die wirklich steinalte 5770 1GB (März 2010) und die läuft bei BF4 leicht übertaktet mit allen Werten auf Mittel ziemlich gut. Nur jetzt ist eben der Support rum und es wird auch mal ehrlich Zeit.Licherkette hat geschrieben:Es geht mir nicht um gefühlt, mir geht es um Zukunft. Ich habe vor ca 4 Jahren eine AMD HD7850 gekauft, die läuft heute noch.

Sie war die sparsamste im Feld, glaube Verbrauch um die 100 Watt. Performance Mittelmaß, bis BF3 hat sie auf mittleren Settings gut mithalten können.

Seit BF4 ist sie unterirdisch.

[...]

Meines Erachtens nach wird es bei Windows bleiben.Licherkette hat geschrieben:[...]Win10 möchte ich so lange wie möglich umgehen, am liebsten wäre mir Vulkan, da Plattformunabhängig und später auch mit Linux möglich. Ich benutze Windows zu Hause eigentlich nur noch zum Zocken.

Die Frage ist: Werden Zocker jemals auf Linux umsteigen oder Microsofts Diktatur treu bleiben?

[...]

Zum Rest kann ich nichts sagen, einfach viel zu weit weg von den Themen.

Zuletzt geändert von ftn|smokin' am 07.09.2016, 13:58, insgesamt 1-mal geändert.

- Roland von Gilead

- verdammt coole sau

- Beiträge: 13180

- Registriert: 02.07.2003, 20:05

- Wohnort: wo die Kühe wilder als die Frauen sind !

- Kontaktdaten:

@lichi: ....async Compute - ich denke wenn es benötigt wird nvidia es liefern (also nach pascal).

- Windows wird bleiben! Linux wird sich nicht durchsetzen, da würde ich eher Android (zwar auch linux) vorne sehe ....

- nvida treiber - seit der fermi Serie (GTX 560 Mai. 2011, danach 580, 670, 970, 1070) keine Probleme, davor hatte ich eine ATI/AMD 5850 die hab ich u.a. wg. Treiberprobleme retourniert. Seitdem hat mich auch keine AMD Karte mehr so richtig überzeugt.

AMD entwickelt vorbildlich an technischen Neuerungen - nvidia dagegen was der Markt gerade braucht.

Beste Beispiel - doom - vulkan api - da zieht AMD alles weg.

Nvidia, nö - dagegen in fast allen anderen die Nase vorn. Der Käufer sieht einen Bench wo AMD führt und kann jetzt spekulieren. Bringt in das was in den nächsten 1-2 Jahren - halt, da ist die VGA eh wieder überholt

Das Problem ist nicht die AMD Hardware, nein es gibt zuwenige Spiel Engines wo AMD mit Ihrer technik auftrumpfen kann, und es sieht auch nicht so aus als ob sich das die nächste zeit schlagartig ändern wird.

7850 released 3/2012 ( https://de.wikipedia.org/wiki/AMD-Radeon-HD-7000-Serie ) - lief schon unter BF4 nicht gut?

Tequillo hat eine GTX660ti released 8/2012 ( https://de.wikipedia.org/wiki/Nvidia-Geforce-600-Serie )- müsste von den Werten vergleichbar bzw. der Pendant zur 7850 sein. siehe:

https://www.computerbase.de/forum/showt ... ?t=1090466

Die läuft sogar gut mit BF1. Da spielt aber auch noch der Unterbau eine Rolle, da AMDs GPUs von einer schwachen CPU mehr ausgebremst wird (unter DX11 ) .

) .

- Windows wird bleiben! Linux wird sich nicht durchsetzen, da würde ich eher Android (zwar auch linux) vorne sehe ....

- nvida treiber - seit der fermi Serie (GTX 560 Mai. 2011, danach 580, 670, 970, 1070) keine Probleme, davor hatte ich eine ATI/AMD 5850 die hab ich u.a. wg. Treiberprobleme retourniert. Seitdem hat mich auch keine AMD Karte mehr so richtig überzeugt.

AMD entwickelt vorbildlich an technischen Neuerungen - nvidia dagegen was der Markt gerade braucht.

Beste Beispiel - doom - vulkan api - da zieht AMD alles weg.

Nvidia, nö - dagegen in fast allen anderen die Nase vorn. Der Käufer sieht einen Bench wo AMD führt und kann jetzt spekulieren. Bringt in das was in den nächsten 1-2 Jahren - halt, da ist die VGA eh wieder überholt

Das Problem ist nicht die AMD Hardware, nein es gibt zuwenige Spiel Engines wo AMD mit Ihrer technik auftrumpfen kann, und es sieht auch nicht so aus als ob sich das die nächste zeit schlagartig ändern wird.

7850 released 3/2012 ( https://de.wikipedia.org/wiki/AMD-Radeon-HD-7000-Serie ) - lief schon unter BF4 nicht gut?

Tequillo hat eine GTX660ti released 8/2012 ( https://de.wikipedia.org/wiki/Nvidia-Geforce-600-Serie )- müsste von den Werten vergleichbar bzw. der Pendant zur 7850 sein. siehe:

https://www.computerbase.de/forum/showt ... ?t=1090466

Die läuft sogar gut mit BF1. Da spielt aber auch noch der Unterbau eine Rolle, da AMDs GPUs von einer schwachen CPU mehr ausgebremst wird (unter DX11

Zuletzt geändert von Roland von Gilead am 07.09.2016, 13:54, insgesamt 2-mal geändert.

- Lord_Vader

- Geschäftsmodell

- Beiträge: 4909

- Registriert: 14.10.2002, 10:02

- Wohnort: Duisburg

- Kontaktdaten:

Was willst du bei Nvidia Treibern wissen? Da kommt eine Meldung das ein neuer Treiber da ist, dann installiert man den (nur Treiber und PhysX, den HD Audio und 3D Brillenzusatz brauch ich nicht) und fertig.

Recht unspektakulär das ganze. Braucht nichtmals einen reboot.

In BF1 hatte ich noch garkeine Probleme. Läuft einfach. Und das ganze unter Win10. Und ja, mein PC daheim ist auch nur eine Daddelkiste.

Recht unspektakulär das ganze. Braucht nichtmals einen reboot.

In BF1 hatte ich noch garkeine Probleme. Läuft einfach. Und das ganze unter Win10. Und ja, mein PC daheim ist auch nur eine Daddelkiste.

<~>

Meine Threema ID: 9CATSS5P

Meine Threema ID: 9CATSS5P

- Licherkette

- Administrator

- Beiträge: 1288

- Registriert: 08.12.2002, 13:46

- Wohnort: Langenselbold

@Roland: BF4 würde mit der HD7850 laufen, aber halt nicht mehr auf meinem Unterbau, der ist 9 Jahre alt (Core2Quad 9550). Hatte zuletzt ab 48 Spielern 100% CPU-Last, was ja dann eindeutig ist.

Habe ein weiteres System hier von Fasthand mit i5 CPU, da läuft das noch Alles. Den PC nutze ich gerade , da er sonst hier nur rumsteht

, da er sonst hier nur rumsteht

Habe ein weiteres System hier von Fasthand mit i5 CPU, da läuft das noch Alles. Den PC nutze ich gerade

Wissen ist Macht, nix Wissen macht auch nix